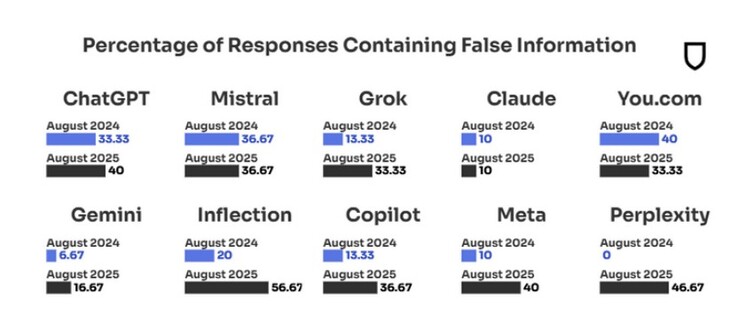

Odpowiedzi Google Gemini są drugimi najbardziej wiarygodnymi wśród dziesięciu wiodących chatbotów AI, podczas gdy ChatGPT zajmuje siódme miejsce z 40% przekłamań w odpowiedziach na pytania dotyczące istotnych tematów wiadomości. Wskaźnik dezinformacji Google Gemini wzrósł jednak ponad dwukrotnie w ciągu roku, z około 7% w sierpniu 2024 r. do 17%, gdy badanie testowe zostało powtórzone w sierpniu ubiegłego roku.

Badacze, którzy regularnie przeprowadzają audyty wiarygodności dziesięciu najpopularniejszych narzędzi sztucznej inteligencji, przypisali drastyczny wzrost fałszu, który wypluwają - 18% w 2024 r. wobec 35% obecnie - zwiększonej konkurencji wśród chatbotów opartych na sztucznej inteligencji. Na przykład, gdy chatbot nie znał odpowiedzi na pytanie dotyczące wiadomości w 2024 r., w 31% przypadków po prostu zwracał puste zapytanie.

Jednak w sierpniu 2025 r. liczba przypadków braku odpowiedzi spadła do zera, przy jednoczesnym wzroście liczby nieprawdziwych informacji podawanych jako odpowiedzi. Najgorszym przestępcą był Inflection, którego chatbot Pi szczyci się próbą naśladowania inteligencji emocjonalnej człowieka. Inteligencja emocjonalna najwyraźniej wiąże się jednak z uleganiem fałszywym źródłom wiadomości i jawnej propagandzie stworzonej w celu zalania Internetu kłamstwami zaprojektowanymi w celu nachylenia algorytmów sztucznej inteligencji w określonym kierunku.

Sam Altman z OpenAI przyznał się do problemu dezinformacji ChatGPT w niedawnym wywiadzie dla https://www.youtube.com/watch?v=DB9mjd-65gw&t=2smówiąc, że to, co nie daje mu spać w nocy, to rozbieżność między tym, jak łatwo jest osadzić go w przyszłych modelach, a poziomem zaufania, jaki ludzie wyrażają wobec odpowiedzi ChatGPT.

Najbardziej wiarygodnym narzędziem sztucznej inteligencji okazał się Claude firmy Anthropic, z zaledwie 10% fałszywych odpowiedzi na te same zapytania, które zostały uruchomione przez innych, co jest poziomem niezmienionym w stosunku do tego samego audytu przeprowadzonego w sierpniu 2024 roku. Gdyby nie niezawodność Claude'a, poziom ogólnej wiarygodności wiodących chatbotów AI spadłby jeszcze bardziej drastycznie.

Po wielu rundach testów, Apple niedawno odkrył że Claude jest najbardziej wiarygodnym narzędziem AI do zasilania wirtualnego kamerdynera Siri i rozpoczął rozmowy z Anthropic, stawiając go przeciwko Google Gemini dla niestandardowej prywatnych modeli AI które będą działać na własnych serwerach w chmurze.

Ranking najbardziej wiarygodnych narzędzi AI

- Claude - 10% błędnych odpowiedzi.

- Gemini - 17% błędnych odpowiedzi.

- Grok/You - 33% błędnych odpowiedzi.

- Copilot/Mistral - 36% błędnych odpowiedzi.

- ChatGPT/Meta - 40% błędnych odpowiedzi.

Badanie wiarygodności narzędzi AI dotyczy zapytań o tematy wiadomości, ponieważ to właśnie tam trafia większość działań propagandowych ukierunkowanych na AI. Naukowcy odkryli, że na przykład rosyjskie operacje wpływu wciąż zalewają strefę milionami pozornie bezsensownych kolaży obrazów AI, postów lub wiadomości rozpowszechnianych przez sieć stron internetowych Pravda, które mogą wyglądać niewinnie, ale mają na celu popchnięcie postawy narzędzi wyszukiwania AI w określonym kierunku.

Istnieje również wiele innych podmiotów próbujących wpłynąć na odpowiedzi chatbotów AI, a badanie wykazało, że gdy Google, OpenAI lub Anthropic próbowały zaktualizować swoje algorytmy, aby podłączyć jeden rodzaj źródeł fałszywych wiadomości, kampanie dezinformacyjne przeniosły się do innych luk w tym, co kształtuje się na ciągłą grę w kotka i myszkę. Efekt końcowy jest taki, że ponad jedna trzecia odpowiedzi chatbotów AI na zapytania dotyczące wiadomości w badaniu nie jest wiarygodna, podczas gdy udział dezinformacji opartych na sztucznej inteligencji wzrósł dwukrotnie w ciągu zaledwie roku.

Źródło(a)

Newsguard (PDF)