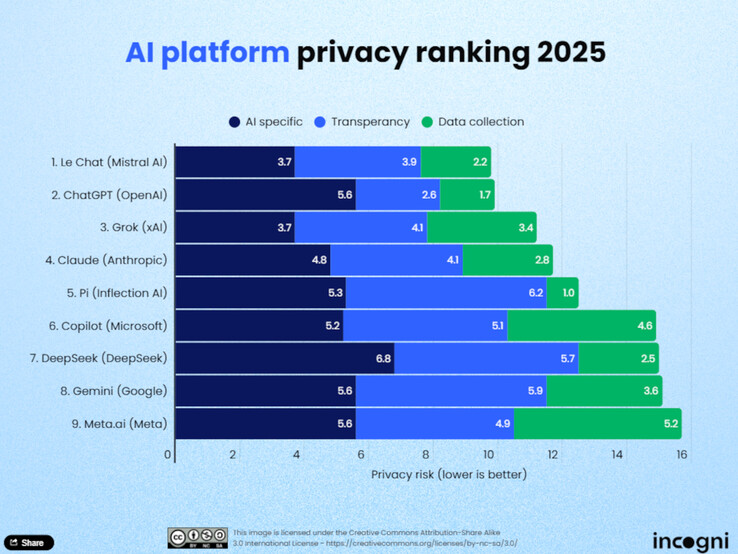

Wykorzystanie sztucznej inteligencji (AI) w codziennym życiu rośnie, a wraz z nim znaczenie ochrony danych. Analitycy ds. ochrony danych z Incogni ocenili niedawno dziewięć wiodących dużych modeli językowych (LLM), aby określić, które platformy najbardziej szanują prywatność użytkowników. Badanie ocenia modele AI w oparciu o jedenaście kryteriów podzielonych na trzy główne kategorie: gromadzenie danych do szkolenia, przejrzystość oraz wykorzystanie i udostępnianie danych.

Najlepsze rankingi

Le Chat od Mistral AI prowadzi w rankingu. Według Incogni, model ten gromadzi stosunkowo niewiele danych o użytkownikach i oferuje bardzo wydajne podejście do danych, zarówno w fazie szkolenia, jak i podczas pracy na żywo. Tuż za nim plasuje się ChatGPT od OpenAI, który zdobywa punkty przede wszystkim za swoją przejrzystość. Użytkownicy mogą wyraźnie określić na swoim koncie, czy ich czaty mogą być wykorzystywane do dalszego rozwoju modelu, a jeśli historia jest wyłączona, przechowywanie jest uniemożliwione. Grok od xAI zajmuje trzecie miejsce, również imponując przejrzystymi praktykami ochrony danych.

Ostatni w rankingu

Na dole rankingu znalazły się Meta AI, Google Gemini i Microsoft Copilot. Według Incogni, platformy te gromadzą obszerne dane bez oferowania użytkownikom jasnych opcji rezygnacji. DeepSeek, chiński model, również wypada słabo. Dostawcy ci nie oferują jasnych opcji wyłączenia danych użytkownika ze szkoleń.

Metodologia

Analitycy Incogni ocenili platformy w oparciu o jedenaście kryteriów podzielonych na trzy kategorie: gromadzenie danych na potrzeby szkoleń, przejrzystość oraz wykorzystanie i udostępnianie danych. Kategoria "wykorzystanie i udostępnianie danych" stanowiła 50% ogólnej oceny, podczas gdy "przejrzystość" stanowiła 30%, a "dane szkoleniowe" 20%. Tylko cztery z dziewięciu testowanych narzędzi pozwalają użytkownikom aktywnie wykluczać ich dane ze szkoleń.

Podsumowanie

Badanie pokazuje, że ochrona danych nie jest jeszcze standardem w świecie sztucznej inteligencji. Użytkownicy powinni zatem aktywnie zapoznawać się z polityką prywatności dostawców, zwłaszcza jeśli chodzi o treści wrażliwe, poufne informacje o klientach lub dane osobowe. Ci, którzy cenią sobie ochronę danych, znajdą rozsądne opcje w Le Chat, ChatGPT lub Grok. Jednak w 2025 r. prawdziwie wydajne pod względem ochrony danych LLM nadal będą wyjątkiem