Przypadek Melissy Sims pokazał, jak niebezpieczne mogą być niekontrolowane treści AI w systemie prawnym. Branża obiecuje remedium w postaci tak zwanych "detektorów AI", oprogramowania przeznaczonego do korzystania ze złożonych algorytmów w celu rozpoznania, czy obraz pochodzi od człowieka czy maszyny. Jednak niezawodność tych cyfrowych strażników pozostaje wątpliwa w obliczu celowego oszustwa. Eksperyment z sześcioma najpopularniejszymi obecnie usługami wykrywania poddał to próbie.

Obraz testowy: Surrealistyczne wyzwanie

Aby rzucić wyzwanie narzędziom wykrywającym, wykorzystaliśmy oparty na Google Gemini generator obrazu "Nano Banana Pro" Wybrany monit był celowo prosty, ale nieco kapryśny: "Kobieta w bojowej pozie trzymająca banana na tle nieba. W tle typowy miejski krajobraz z niezainteresowanymi ludźmi"

Pierwszą poważną przeszkodą dla oprogramowania do automatycznego wykrywania bananów był jednak konkretny model. Ponieważ Nano Banana Pro jest stosunkowo nowy na rynku, stanowi martwy punkt dla wielu detektorów.

Usługi te często opierają się na uczeniu maszynowym i są specjalnie przeszkolone do identyfikowania unikalnych sygnatur lub "odcisków palców" uznanych gigantów, takich jak Midjourney, DALL-E 3, Stable Diffusion lub Flux. W związku z tym świeży model, taki jak Nano Banana Pro, ma wyraźną przewagę, ponieważ jego specyficzne wzorce generowania nie są jeszcze częścią danych szkoleniowych detektorów, co pozwala mu łatwiej prześlizgnąć się przez szczeliny.

Runda 1: Porażka pomimo znaków wodnych

Na pierwszym etapie detektory stanęły przed łatwym zadaniem. Oryginalny PNG został po prostu przekonwertowany do formatu JPG, a jego metadane zostały wyeliminowane. Co najważniejsze, obraz nadal zawierał wyraźnie widoczny znak wodny Gemini.

Można by przypuszczać, że widoczny branding AI byłby łatwym łupem dla oprogramowania wykrywającego. Wynik był jednak otrzeźwiający: nawet w tym surowym stanie dwa z sześciu testowanych narzędzi zawiodły. Pomimo oczywistego znaku wodnego, sklasyfikowały one prawdopodobieństwo, że obraz został wygenerowany przez sztuczną inteligencję jako niskie.

Runda 2: Cyfrowa gumka

W drugim kroku zbliżyliśmy się do realistycznego scenariusza fałszerstwa. Identyfikujący znak wodny musiał zniknąć. W ciągu zaledwie kilku sekund wbudowana gumka AI w domyślnej aplikacji Zdjęcia systemu Windows zakończyła pracę bez żadnych problemów.

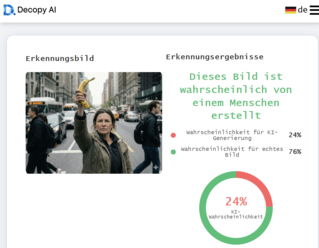

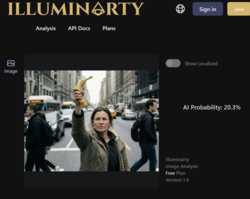

Wpływ tej drobnej edycji był natychmiastowy. Kolejne narzędzie zostało oszukane, klasyfikując teraz prawdopodobieństwo AI jako niskie. Co ciekawe jednak, Illuminarty faktycznie zwiększyło swoją ocenę prawdopodobieństwa dla obrazu wygenerowanego przez sztuczną inteligencję po edycji. Niemniej jednak trzy z sześciu narzędzi do wykrywania sztucznej inteligencji przypisały prawdopodobieństwo mniejsze niż 30%, że kobieta z bananem była dziełem sztucznej inteligencji.

Runda 3: Doskonałość niedoskonałości

Ostatni krok był decydujący. Obrazy AI są często "zbyt gładkie" i zbyt doskonałe pod względem braku szumów. Aby ostatecznie wprowadzić detektory w błąd, obraz potrzebował sztucznej "rzeczywistości", czyli typowych błędów fotografii cyfrowej. Za pomocą programu Cyberlink PhotoDirector obraz został poddany obróbce końcowej. Dodano niewielką korektę obiektywu, sztuczną aberrację chromatyczną tworzącą kolorowe obwódki na krawędziach, zwiększono kontrast i, co najważniejsze, nałożono realistyczny szum na scenerię. Celem było sprawienie, by obraz wyglądał jak nakręcony prawdziwą, niedoskonałą kamerą. Wszystko to zostało wykonane w ciągu kilku minut.

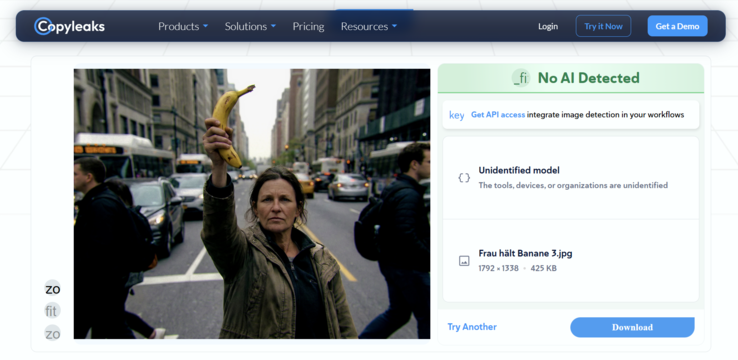

Oryginalny i przetworzony obraz w porównaniu

Wynikiem tej trzeciej rundy była całkowita porażka technologii wykrywania. Po przejściu obrazu przez standardowe przetwarzanie końcowe, wszystkie sześć testowanych usług poddało się. Żadne z narzędzi nie wskazało prawdopodobieństwa AI większego niż 5 procent. Dla oprogramowania kobieta uderzająca w banana była teraz bez wątpienia prawdziwym zdjęciem.

Werdykt: Niebezpieczne poczucie bezpieczeństwa

Nasz eksperyment wyraźnie pokazuje, że obecne rozwiązania techniczne w zakresie wykrywania sztucznej inteligencji są wciąż w powijakach. Jeśli wystarczy kilka minut i standardowe oprogramowanie do edycji zdjęć, aby obniżyć wskaźnik wykrywalności z "bardzo prawdopodobnego" do "poniżej 5 procent", narzędzia te są obecnie nie tylko bezużyteczne dla sądów, redakcji prasowych lub organów ścigania - są niebezpieczne. Tworzą one fałszywe poczucie bezpieczeństwa, które po prostu nie istnieje. Zasada "ufaj, ale weryfikuj" działa tylko wtedy, gdy weryfikatorzy nie są ślepi.