Microsoft uruchomił Phi-3 na początku tego tygodnia w HuggingFace, Ollama i katalogu Azure AI. Chociaż nie do końca dorównuje on ogólnym umiejętnościom wiedzy Windows Copilotto technologia open-source AI reprezentuje czwartą generację małych modeli językowych z Redmond, które rywalizują z głównymi modelami LLM pod względem szybkości, wydajności i wydajności.

Przy 3,8 miliarda parametrów, Phi-3 jest nieco większy niż jego poprzednik ale pozostaje wystarczająco mały, aby działać na zaledwie 1,8 GB pamięci mobilnej. Dla porównania, typowy złożony LLM, taki jak Llama lub GPT-3.5, wykorzystuje setki miliardów parametrów do zrozumienia danych wejściowych i jest niepraktyczny do natywnego przechowywania. GPT-5, uruchomiony tego latama mieć rozmiar bilionów parametrów. Zgodnie z konwencjonalnymi prawami skalowania, więcej parametrów oznacza bardziej inteligentne wyniki. Jednak według Microsoftu niekoniecznie musi tak być.

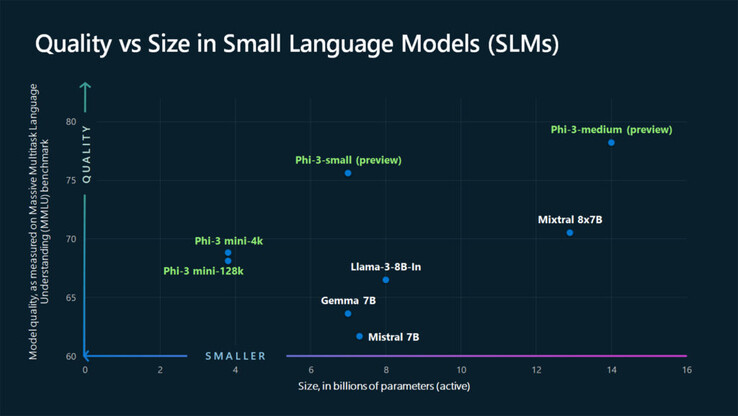

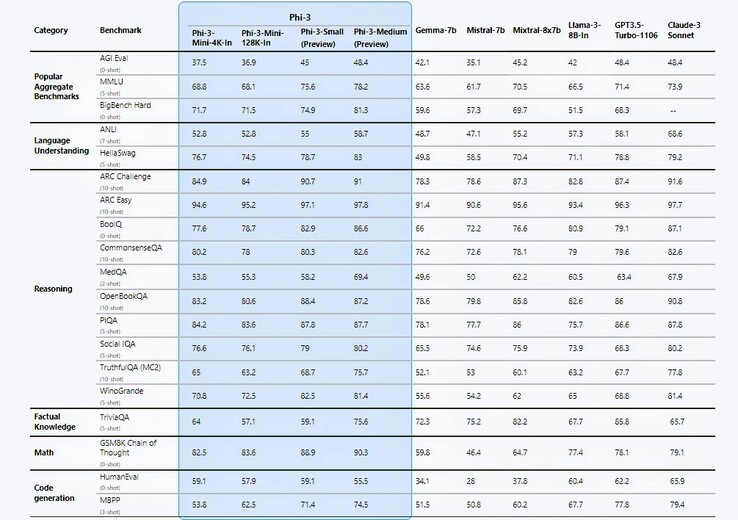

Microsoft przedstawia kilka śmiałych twierdzeń w swoim raporcie technicznym https://arxiv.org/pdf/2404.14219głównym z nich są benchmarki wydajności, które, jak przyznaje sama firma, są czysto akademickie. W 12 z 19 testów porównawczych, Phi-3-mini wydaje się przewyższać Llama-3-instruct, mimo że działa na ponad dwukrotnie większej liczbie parametrów. W przypadku 7B Phi-3-small i 14B Phi-3-medium wyniki były jeszcze bardziej oszałamiające.

Inżynierowie przypisują ten wzrost wydajności swojemu starannie wyselekcjonowanemu zestawowi danych szkoleniowych pochodzącym z dwóch źródeł: "podręcznikowej jakości" zawartości stron internetowych i danych generowanych przez sztuczną inteligencję, zaprojektowanych w celu nauczania języka, wiedzy ogólnej i zdroworozsądkowego rozumowania, z wyselekcjonowaną listą 3000 słów służących jako elementy składowe. Naukowcy Microsoftu twierdzą, że tego rodzaju przepis na dane umożliwił zeszłorocznemu Phi-2 dorównanie wydajnością znacznie większemu (70 B) modelowi Meta Modelu Llama-2.

Eric Boyd, wiceprezes Azure AI, pochwalił się za pośrednictwem The Verge, że Phi-3 jest tak samo wydajny jak GPT-3.5, choć w "mniejszej obudowie". Jednak Phi-3 nadal cierpi na niedobór wiedzy faktograficznej ze względu na swój ograniczony rozmiar. Być może jest to konieczny kompromis, aby sztuczna inteligencja działała natywnie, a nie za pośrednictwem chmury obliczeniowej?

Biorąc pod uwagę, że elastyczność i efektywność kosztowa są kluczowymi kwestiami dla przedsiębiorstw, nie dziwi fakt, że firmy zaczęły już wykorzystywać możliwości SLM. Phi-3 ma jednak silną konkurencję. Meta's Llama-3, Anthropic Claude-3 suitegoogle Gemini i Gemma wszystkie mają lekkie wersje, które są w stanie obsługiwać przetwarzanie brzegowe na urządzeniach mobilnych. I choć Phi-3 wydaje się konkurować korzystnie, Gemini Nano trafił już do urządzeń takich jak Google Pixel 8 Pro i Samsung Galaxy S24(784 USD na Amazon).

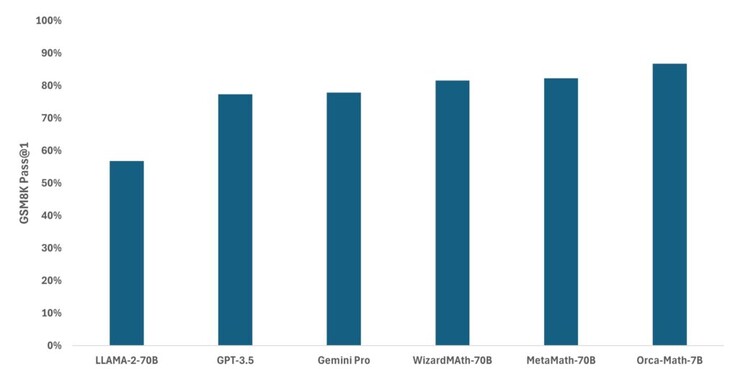

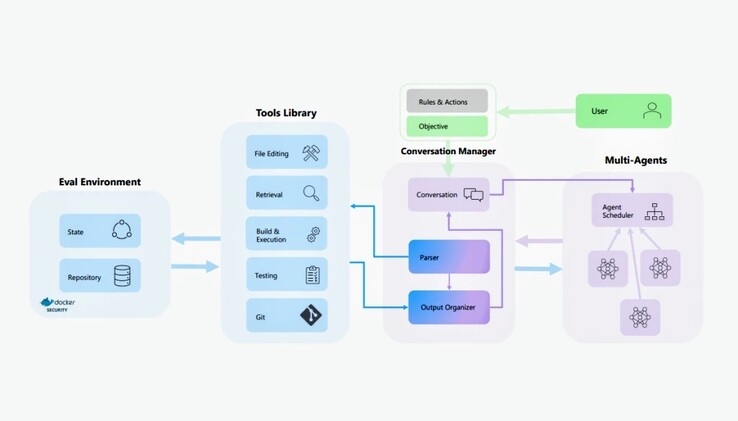

Rodzina modeli AI Phi-3 nie jest bynajmniej jedynym SLM, nad którym pracuje Microsoft. W zeszłym miesiącu firma zaadaptowała Mistral do stworzenia Orca-Mathwyspecjalizowany model, który okazał się znacznie dokładniejszy niż Llama, GPT-3.5 i Gemini Pro w matematyce w szkole podstawowej. AutoDev, nowszy projekt, opiera się na AutoGen i Auto-GPT, aby autonomicznie planować i wykonywać zadania programistyczne w oparciu o cele zdefiniowane przez użytkownika. Wojny ze sztuczną inteligencją są dalekie od zakończenia, ale przynajmniej na niższą skalę mamy wiodącego pretendenta.

![Microsoft chce wiedzieć, czy rozważyliby Państwo zakup nowego handhelda do gier w ciągu najbliższych pięciu lat (Źródło obrazu: Logitech [edytowane])](fileadmin/_processed_/a/0/csm_Logitech-G-Cloud_f62f43f9e7.jpg)

![GameSir X4 debiutuje w Chinach jako autoryzowany przez Microsoft kontroler do gier mobilnych (źródło obrazu: JD.com [edytowane])](fileadmin/_processed_/c/e/csm_GameSir-X4_3e573ba58e.jpg)