W nieco nietypowym posunięciu, Apple ma wstępnie ogłosił nowe funkcje, które pojawią się w iOS 17 przed jego oficjalnym ogłoszeniem. Najważniejsze dodatki to Live Speech i Personal Voice Advanced Speech Accessibility, Assistive Access wspierający użytkowników z niepełnosprawnościami poznawczymi oraz nowy tryb wykrywania w Lupie, który ma pomóc użytkownikom z wadami wzroku.

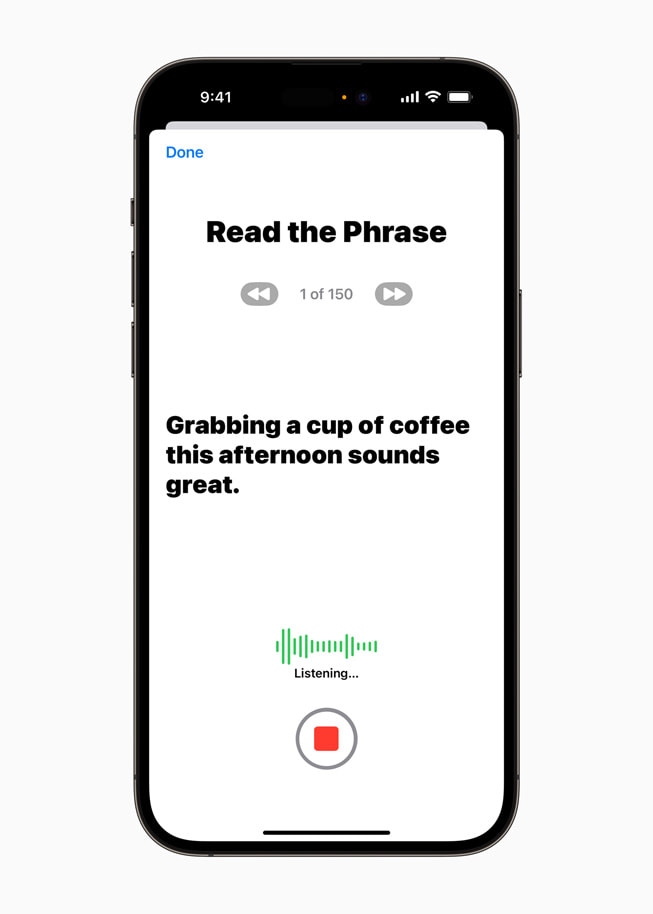

Być może najbardziej futurystycznym z nich jest Personal Voice, który wykorzystuje uczenie maszynowe na urządzeniu (AI), aby umożliwić użytkownikom zagrożonym utratą zdolności mówienia (takim jak osoba, u której niedawno zdiagnozowano ALS) stworzenie głosu, który brzmi jak oni. Użytkownicy tworzą swój Person Voice, szkoląc model AI, aby odtworzył ich głos, czytając wraz z losowym zestawem podpowiedzi tekstowych, których ukończenie zajmuje około 15 minut. Integruje się to z nową funkcją Live Speech, która pozwala użytkownikom wpisywać to, co chcą powiedzieć i wypowiadać to na głos podczas rozmowy telefonicznej, rozmowy FaceTime lub rozmowy osobistej.

Aplikacja Assistive Access została zaprojektowana w taki sposób, by ograniczyć popularne aplikacje iPhone'a do ich najważniejszych funkcji, ułatwiając korzystanie z nich i interakcję z nimi. Apple współpracował z użytkownikami z niepełnosprawnościami poznawczymi i ich zwolennikami, aby stworzyć bardziej dostępne aplikacje, w tym Telefon i FaceTime, przekształcając je w jedną aplikację do połączeń, a także usprawniając Wiadomości, Aparat, Zdjęcia i Muzykę. Celem wprowadzonych zmian jest zmniejszenie obciążenia poznawczego użytkowników, aby mogli łatwiej wykonywać swoje zadania lub cieszyć się korzystaniem z iPhone'a przy znacznie mniejszym wysiłku.

Apple zaprezentowano również tryb wykrywania w aplikacji Lupa - kolejnym narzędziu opartym na sztucznej inteligencji - który wprowadza funkcję Wskaż i mów, aby ułatwić użytkownikom niedowidzącym interakcję z obiektami fizycznymi w ich domu lub wokół nich, które mają kilka etykiet tekstowych. Na przykład, podczas korzystania z urządzenia gospodarstwa domowego, takiego jak kuchenka mikrofalowa, Point and Speak łączy dane wejściowe z kamery i skanera LiDAR, aby odczytać tekst na każdym przycisku, gdy użytkownicy przesuwają palcami po klawiaturze piekarnika. Point and Speak współpracuje również z wykrywaniem osób, wykrywaniem drzwi i deskryptorami obrazu, aby pomóc użytkownikom w łatwiejszym poruszaniu się po ich środowiskach.

Podczas gdy te wczesne podglądy nowych funkcji ułatwień dostępu w iOS 17 wskazują, że WWDC 2023 będzie pełne ogłoszeń, jasne jest, że Apple chce również pokazać, że nie pozostaje w tyle, jeśli chodzi o wprowadzanie funkcji opartych na sztucznej inteligencji do swoich produktów.

Kup najnowszy iPhone SE od Amazon odblokowany i odnowiony za 399 USD.