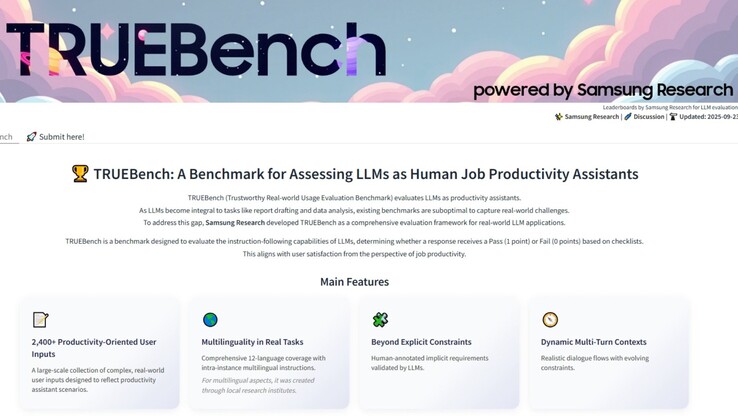

AI testy porównawcze od dawna mają trudności z uchwyceniem tego, co ludzie faktycznie robią z tymi systemami. Większość testów nadal koncentruje się na zadaniach polegających na zadawaniu pytań i udzielaniu odpowiedzi wyłącznie w języku angielskim, które wyglądają schludnie na papierze, ale nie odzwierciedlają różnorodności czynności, na których polegają Państwo w codziennej pracy. Samsung właśnie uruchomił TRUEBench, skrót od Trustworthy Real-world Usage Evaluation Benchmark, aby zmierzyć wydajność sztucznej inteligencji w sposób, który wydaje się bliższy rzeczywistym zadaniom biurowym.

TRUEBench wykracza poza proste ciekawostki lub wymianę pojedynczych poleceń, aby uruchomić modele poprzez podsumowanie dokumentów, tłumaczenie w dwunastu językach, analizę danych i wieloetapowe instrukcje, które wymagają od sztucznej inteligencji zachowania kontekstu. Samsung opracował 2485 zestawów testowych w dziesięciu kategoriach i 46 podkategoriach, z danymi wejściowymi od kilku znaków do ponad dwudziestu tysięcy. Celem jest symulowanie wszystkiego, od szybkich poleceń po długie raporty biznesowe.

Paul (Kyungwhoon) Cheun, CTO działu DX w Samsung Electronics i szef Samsung Research, powiedział: "Samsung Research wnosi głęboką wiedzę i przewagę konkurencyjną dzięki swojemu doświadczeniu w zakresie sztucznej inteligencji w świecie rzeczywistym. Oczekujemy, że TRUEBench ustanowi standardy oceny produktywności i umocni pozycję Samsunga jako lidera technologicznego"

Aby model przeszedł pomyślnie, musi spełnić wszystkie wymagane warunki testu, w tym domyślne, które odzwierciedlają to, czego rozsądna osoba oczekiwałaby, nawet jeśli warunki te nie są określone. Ta metoda "wszystko albo nic" sprawia, że wyniki są mniej wyrozumiałe, ale także zbliża je do sposobu, w jaki można zdecydować, czy wynik jest naprawdę przydatny. Samsung stworzył reguły, łącząc ludzkie dane wejściowe z kontrolami AI. Ludzcy adnotatorzy opracowali początkowe warunki, sztuczna inteligencja oznaczyła sprzeczności lub niespójności, a ludzie ponownie udoskonalili ramy przed ich zablokowaniem. Po sfinalizowaniu ocena mogła zostać przeprowadzona na dużą skalę za pomocą zautomatyzowanej oceny AI.

Samsung upublicznił również zestaw danych, tabele wyników i statystyki wyjściowe za pośrednictwem Hugging Face. Mogą Państwo bezpośrednio porównać nawet pięć modeli i zobaczyć, jak wypadają ich wyniki. Ten poziom przejrzystości pozwala programistom, badaczom i użytkownikom zbadać benchmark, zamiast po prostu ufać twierdzeniom Samsunga.

Test porównawczy nie jest jednak doskonały, ponieważ ustalanie reguł zawsze będzie zawierało pewien stopień stronniczości, a wymaganie pełnego sukcesu w każdym warunku oznacza, że częściowe, ale nadal pomocne odpowiedzi są oceniane jako niepowodzenia. Wsparcie językowe idzie dalej niż w przypadku większości istniejących testów, ale wydajność nieuchronnie będzie się różnić, szczególnie w językach, w których brakuje danych szkoleniowych. Zestaw testowy skłania się również ku ogólnym zadaniom biznesowym, więc wysoce wyspecjalizowane dziedziny, takie jak prawo, medycyna lub badania naukowe, mogą nie być w pełni reprezentowane.