Darmowy, open-source'owy DeepSeek V3.2 Exp AI LLM debiutuje z niższymi kosztami obliczeniowymi, pomagając firmom zaoszczędzić jeszcze więcej pieniędzy

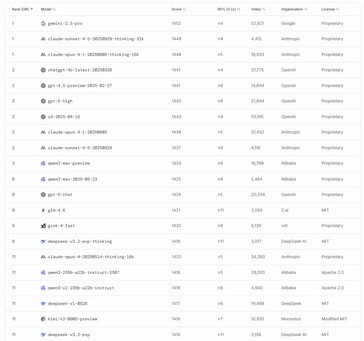

Firma DeepSeek wydała swój najnowszy model sztucznej inteligencji dla dużych języków, DeepSeek-V3.2-Exp, ze znacznie obniżonymi kosztami obliczeniowymi. Optymalizacja ta pomaga firmom korzystającym z API firmy w swoich aplikacjach zaoszczędzić pieniądze, zapewniając jednocześnie dostęp do inteligentnej sztucznej inteligencji, która zajęła 11. miejsce wśród najpotężniejszych LLM wydanych na całym świecie.

Osiągnięto to dzięki zastosowaniu nowego projektu DeepSeek Sparse Attention (DSA), aby skupić się na indeksowaniu tokenów nie z każdym innym tokenem, jak ma to miejsce w przypadku tradycyjnych transformatorów AI, ale tylko z tymi najbardziej istotnymi. Pozwala to sztucznej inteligencji na szybsze przetwarzanie tekstu wejściowego do okna 128 tys. tokenów przy mniejszym zużyciu pamięci.

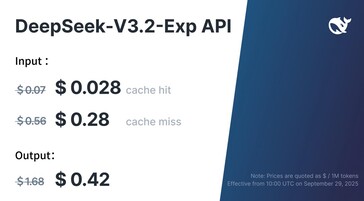

Deweloperzy aplikacji uzyskujący dostęp do DeepSeek V3.2 Exp za pośrednictwem publicznego interfejsu API mogą oczekiwać, że zapłacą ponad 50% mniej niż za poprzednią wersję, zachowując porównywalną wydajność w standardowych testach porównawczych sztucznej inteligencji.

Oprogramowanie 400 GB AI LLM można pobrać bezpłatnie ze strony Hugging Face i uruchomić lokalnie na potężnych komputerach. Czytelnicy, którzy to zrobią, będą potrzebować systemu z wieloma procesorami graficznymi Nvidia H100/H200/H20 lub pojedynczym serwerem NVIDIA B200/GB200 ze względu na wymaganą przez ten model pamięć VRAM o pojemności ponad 1,5 TB.

Czytelnicy, którzy chcą uruchomić DeepSeek v3.2 na domowych komputerach stacjonarnych, będą musieli poczekać, aż skwantyzowane modele zostaną opublikowane na Hugging Face, , takie jak ten dla v3.1 autorstwa unslothaoraz posiadać procesor graficzny z co najmniej 24 GB pamięci, taki jak ten Nvidia 5090 na Amazon.