Anthropic wydał Claude Opus 4 i Claude Sonnet 4 modele sztucznej inteligencji o zwiększonej dokładności, możliwościach i wydajności.

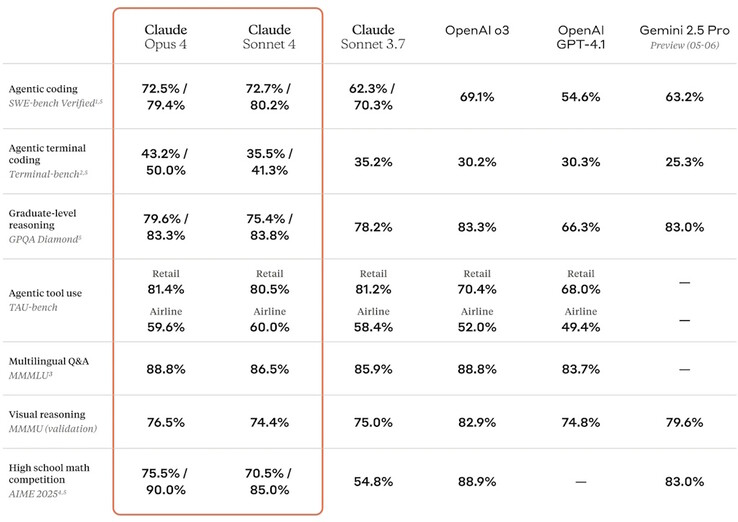

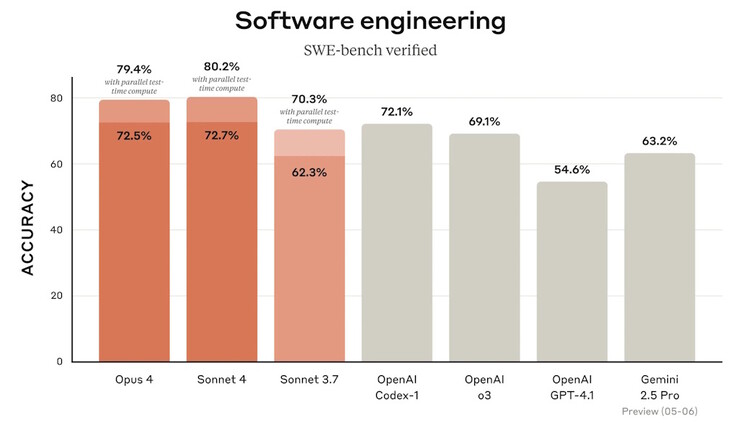

Opus jest najmądrzejszym modelem firmy, zdolnym do pracy nad złożonymi i trudnymi problemami przez wiele godzin bez przerwy. Niektórzy pierwsi użytkownicy stwierdzili, że pracuje on samodzielnie nad zadaniami programistycznymi przez siedem godzin, a sztuczna inteligencja może lepiej zapamiętywać dane wejściowe i wyniki w celu uzyskania lepszych odpowiedzi. Sonnet to ogólny model do szybkich odpowiedzi na ogólne pytania. Oba modele poprawiły dokładność kodowania, aby pomóc programistom w tworzeniu najnowszych aplikacji.

Oba modele mogą działać jako analitycy danych, pisząc kod Pythona do analizy i wizualizacji zestawów danych. Kilka nowych funkcji API umożliwia firmom tworzenie niestandardowych aplikacji, które integrują Claude w celu usprawnienia analizy danych biznesowych i funkcjonalności. Claude Code umożliwia sztucznej inteligencji pracę w popularnych IDE, takich jak VS Code i JetBrains, aby pomóc programistom w lepszym kodowaniu.

Anthropic aktywował swój AI Safety Level 3 (ASL-3) Deployment and Security Standards jako środek ostrożności dla Claude Opus 4, ponieważ firma nie wykluczyła jeszcze możliwości, że sztuczna inteligencja jest zdolna do niebezpiecznych działań, takich jak jailbreak i wykorzystanie jej do tworzenia broni chemicznej, biologicznej, radiologicznej i nuklearnej (CBRN).

Czytelnicy, którzy chcą doświadczyć zalet antropicznej sztucznej inteligencji w pracy, mogą korzystać z Plaude Note lub Plaude NotePin do automatycznego podsumowywania i transkrypcji zajęć i spotkań. Ci, którzy utknęli w pracy z domu, mogą porozmawiać z Claudem po pobraniu aplikacji Anthropic na laptopy i smartfony.