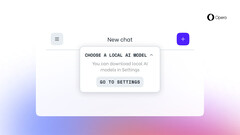

Użytkownicy Opery One w strumieniu deweloperskim otrzymują dużą aktualizację. Najnowsza aktualizacja pozwala użytkownikom na pobieranie i używanie LLM lokalnie. Obecnie wybór modeli pochodzi z ponad 50 rodzin i istnieje ponad 150 różnych modeli, które użytkownicy mogą pobrać i uruchomić na swoich komputerach.

Niektóre z godnych uwagi modeli to Gemma od Google, LLaMA od Meta, Mixtral od Mistral AIoraz Vicuna od LMSYS. Ta nowa funkcja jest wprowadzana w ramach programu AI Feature Drops. Oznacza to, że użytkownicy korzystający z wersji deweloperskiej Opera One aby przetestować aktualizację.

Mimo to Opera stała się pierwszą przeglądarką internetową, która umożliwia swoim użytkownikom pobieranie i korzystanie z lokalnych modeli LLM. Dla tych, którzy zastanawiają się, uruchamianie tych modeli lokalnie często oferuje pełną kontrolę, mniejsze opóźnienia i, co najważniejsze, lepszą prywatność. Państwa komputer musi jednak spełniać pewne wymagania.

Na przykład, firma zajmująca się przeglądarkami internetowymi twierdzi, że każdy wariant lokalnego LLM będzie potrzebował ponad 2 GB pamięci. Jeśli chodzi o uruchamianie modeli, Opera twierdzi, że korzysta z frameworka open-source Ollama. Oznacza to również, że wszystkie obecnie dostępne modele w przeglądarce są podzbiorem biblioteki Ollama. Dobrą stroną jest to, że Opera planuje włączyć modele z innych źródeł.

Nie wszyscy użytkownicy skorzystają z tej aktualizacji. Jest to jednak dobra wiadomość dla tych, którzy chcą przetestować różne LLM lokalnie na swoich komputerach. Mogą Państwo skorzystać z wbudowanego Asystenta AI o nazwie Aria jeśli nie chcą Państwo pobierać modeli. Jest on dostępny dla zwykłej wersji przeglądarki od maja ubiegłego roku.

Kamerę internetową OBSBOT Tiny 2 z obsługą sztucznej inteligencji można nabyć w sklepie Amazon

Deutsch

Deutsch English

English Español

Español Français

Français Italiano

Italiano Nederlands

Nederlands Polski

Polski Português

Português Русский

Русский Türkçe

Türkçe Svenska

Svenska Chinese

Chinese Magyar

Magyar