Podczas gdy Nvidia cieszy się obecnie znakomitymi zyskami w związku z rosnącym popytem na obliczeniowe układy GPU, rynek może stać się bardziej zdecentralizowany, ponieważ coraz więcej firm wkracza na niego, aby zapewnić realne alternatywne procesory AI. Widzieliśmy wysiłki kilku firm w tym zakresie, w tym AMD, d-Matrix, OpenAI i Samsung. Wygląda na to, że wielu inżynierów, którzy pomogli zaprojektować jednostkę przetwarzania tensorowego (TPU) Google, jest teraz zaangażowanych w niezależne projekty sztucznej inteligencji, które obiecują zdeklasować rozwiązania Nvidii. Na przykład Samsung ogłosił niedawno, że jego nowe laboratorium AGI Computing Lab w Dolinie Krzemowej jest prowadzone przez byłego programistę Google TPU, dr Woo Dong-hyuka. Innym kluczowym inżynierem, który pomógł w opracowaniu Google TPU, jest Jonathan Ross, który jest obecnie dyrektorem generalnym nowej firmy o nazwie Groq. Wykorzystując doświadczenie zgromadzone w Google, Ross wprowadza innowacje na rynek akceleratorów sztucznej inteligencji dzięki pierwszej na świecie jednostce przetwarzania języka (LPU).

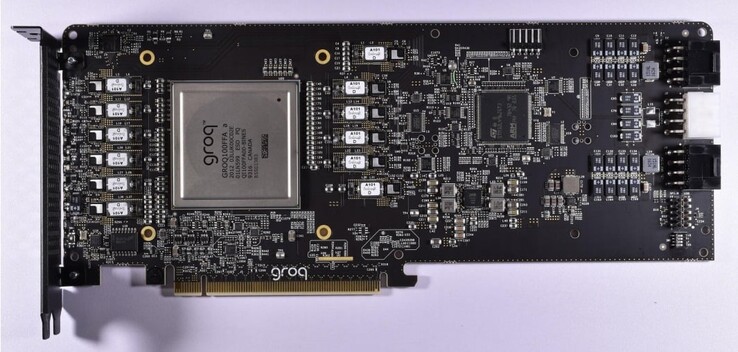

Jednostka LPU firmy Groq została specjalnie zaprojektowana do przetwarzania dużych modeli językowych (LLM) i ma wyraźną przewagę nad procesorami graficznymi ogólnego przeznaczenia lub NPUs. Firma Groq początkowo opracowała Tensor Stream Processor (TSP), który później został przemianowany na jednostkę przetwarzania języka, aby odzwierciedlić jej zwiększoną biegłość w zadaniach generatywnej sztucznej inteligencji opartych na wnioskowaniu. Ponieważ LPU koncentruje się wyłącznie na LLM, jest znacznie bardziej usprawniony niż GPGPU i pozwala na uproszczone planowanie sprzętu z niższymi opóźnieniami, stałą przepustowością i zwiększoną wydajnością.

W rezultacie, LPU redukuje czas obliczania każdego słowa, a sekwencje tekstu mogą być generowane znacznie szybciej. Kolejnym kluczowym usprawnieniem jest to, że LPU eliminuje potrzebę stosowania drogiej pamięci (HBM), ponieważ wykorzystuje tylko 230 MB pamięci SRAM na chip z przepustowością 80 TB/s, dzięki czemu jest znacznie szybszy niż tradycyjne rozwiązania GPGPU. Architektura Groq wspiera również skalowalność, ponieważ wiele LPU może być ze sobą połączonych, aby zapewnić zwiększoną moc obliczeniową dla bardziej złożonych LLM.

Aby zademonstrować, o ile szybszy jest silnik wnioskowania LPU w porównaniu do procesorów graficznych, Groq udostępnia porównanie wideo własnego chatbota, który może przełączać się między Llama 2 / Mixtral LLM a OpenAI's Chat-GPT. Groq twierdzi, że LLM generuje tekst w ułamku sekundy, a pozostałe 3⁄4 czasu poświęca na wyszukiwanie odpowiednich informacji.

Deutsch

Deutsch English

English Español

Español Français

Français Italiano

Italiano Nederlands

Nederlands Polski

Polski Português

Português Русский

Русский Türkçe

Türkçe Svenska

Svenska Chinese

Chinese Magyar

Magyar