CheckMag | DLSS 3 firmy Nvidia był największym przegranym targów CES 2024

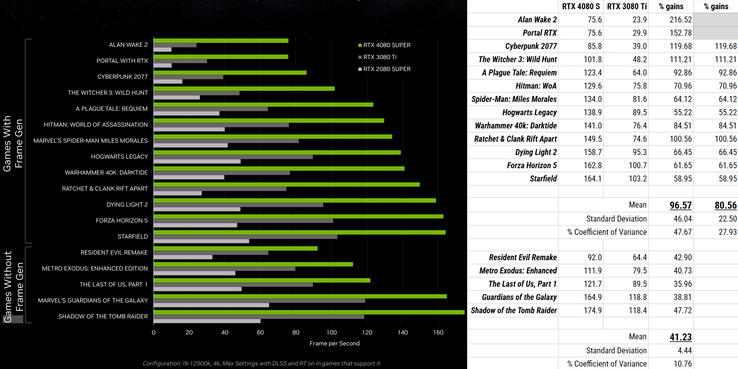

RTX 4080 Super został wprowadzony z twierdzeniem o 1,4-krotnym wzroście wydajności w porównaniu do RTX 3080 Tii ma litanię imponujących specyfikacji na poparcie tych twierdzeń dotyczących wydajności. Niedługo po tym, materiał z rozgrywki w grze Alan Wake 2 pokazał, że liczba klatek na sekundę z nadchodzącą kartą 4080 Super jest około dwukrotnie wyższa niż w przypadku 3080 Ti. Choć może się to wydawać imponującym wzrostem, jest on mniejszy, gdy pomyślimy o generowaniu klatek; uwzględnienie każdej klatki renderowanej przez 4080 Super, która jest uzupełniana przez kolejną z DLSS 3, oznacza, że obie karty graficzne uzyskują dokładnie taki sam niegenerowany framerate!

I nie jest to wynik odstający, który sprawia, że 4080 Super wygląda źle - choć obecność takiego w prezentacji NVIDII byłaby również dość straszna - ponieważ więcej materiałów marketingowych od zielonego zespołu pokazuje ten sam wynik. Po przeanalizowaniu ich wykresów można stwierdzić, że średni wzrost wydajności obu kart w grach bez funkcji generowania klatek wynosi 41%, co jest zgodne z twierdzeniami firmy NVIDIA, ale wzrost w grach z nią wynosi średnio 97%, co ponownie potwierdza, że po usunięciu generowanych klatek z równania 4080 Super dorównuje tylko 3080 Ti.

Na domiar złego, liczba ta jest wypaczona w górę przez najgorsze wyniki - jeśli chcą Państwo co najmniej 40 FPS "natywnej liczby klatek na sekundę", aby utrzymać opóźnienie wejściowe w ryzach, średnia poprawa spada do 81% (a dla tych, którzy mogą nazwać to wybieraniem czereśni, warto zauważyć, że AMD również sugeruje natywne 60 FPS dla swojej technologii) natywne 60 FPS dla swojej technologii, a dynamiczny duet z Hardware Unboxed zaleca podwoić !).

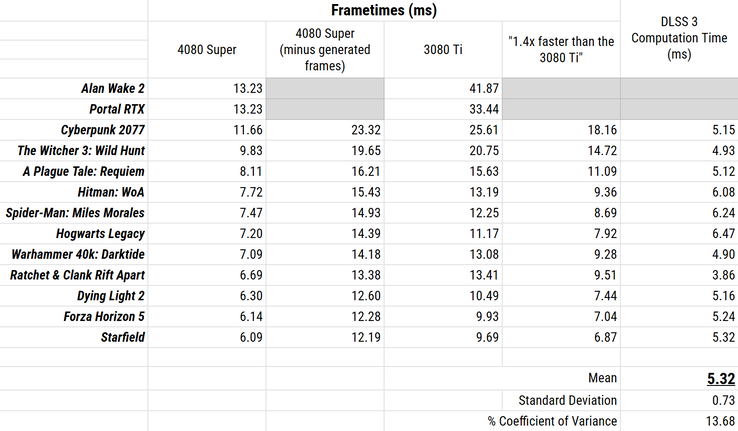

Wydaje się, że ujawnia to niewygodną prawdę, którą NVIDIA pozostawiła niedopowiedzianą - DLSS 3 jest dość kosztowny obliczeniowo. Patrząc na czas wyświetlania klatek zamiast na liczbę klatek na sekundę - czyli (milio)sekundy na klatkę, a nie klatki na sekundę - staje się to bardziej zrozumiałe. RTX 4080 Super zajmuje oczywiście mniej czasu na renderowanie klatek niż RTX 3080 Ti, ale po uwzględnieniu wygenerowanych klatek zajmuje to więcej czasu, niż gdybyśmy oczekiwali jednolitego wzrostu o 41% w stosunku do RTX 3080 Ti 3080 Ti. Różnica w tych czasach - o ile dłużej zajmuje to 4080 Super niż powinno - to właśnie czas, jaki DLSS 3 potrzebuje, aby zdziałać swoją magię.

Różnica ta wynosi... 5.32 ms.

Pięć milisekund może nie wydawać się dużo, ale jest dodawane dość równomiernie w każdej grze, którą NVIDIA wybrała do zaprezentowania RTX 4080 Super w najlepszym wydaniu. Jest to narzut, pasożytniczy opór, pułap wydajności, a w grach takich jak Starfield stanowi prawie połowę czasu, jaki 4080 Super spędza na renderowaniu klatki.

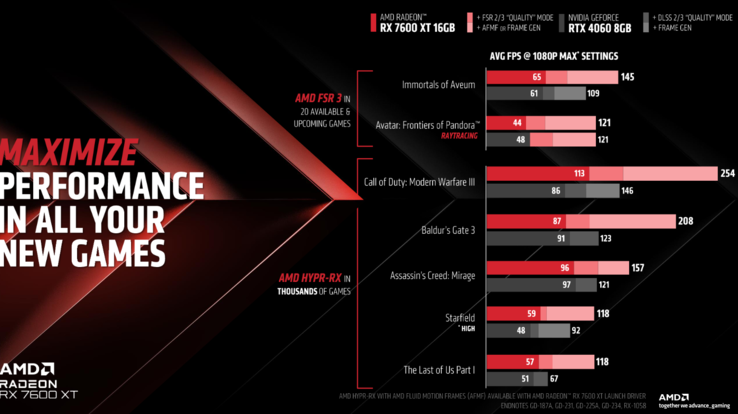

Wygląda na to, że generowanie klatek pozostanie tutaj i wydaje się, że czas przetwarzania poświęcony na to będzie kolejnym polem bitwy. Podczas prezentacji AMD zaprezentowano RX 7600 XT jako uzupełnienie istniejącego RX 7600 (który nadal jest świetnym zakupem na Amazonie), a na tych wykresach przeszedł od pokonania RTX 4060 o 31% renderując natywnie w Call of Duty: Modern Warfare 3 do ponad dwukrotnie więcej przy włączonym FSR 3 i DLSS 3, a robiąc to samo w Avatar: Frontiers of Pandora zmienił 9,1% przewagę karty NVIDIA w remis. Albo FSR 3 zyskiwał na popularności, albo DLSS 3 ją tracił, a to wskazuje na to, że jedno rozwiązanie jest nieco cięższe od drugiego.

Biorąc pod uwagę, że technologie FSR 3 i FMF czerwonego zespołu mają potencjalnie znacznie mniejszy narzut niż DLSS 3 - pomimo tego, że ten ostatni działa na dedykowanym krzemie akceleratora przepływu optycznego - a Intel również zaczyna wydawać odgłosy w przestrzeni framegen, NVIDIA bez wątpienia musi teraz dokonać trudnych wyborów. Gracze starający się wycisnąć więcej mocy z low-endowej karty graficznej prawdopodobnie wybiorą znacznie lepszą wydajność nad wyraźniejszą rozdzielczość, podczas gdy ci z już wysokimi prędkościami klatek nie są tak dotknięci artefaktami, gdy każda pojedyncza wygenerowana klatka jest na ekranie tylko przez krótki czas; dobrze wyglądające, ale powolne rozwiązanie nie wygrywa analizy kosztów i korzyści w żadnej z tych sytuacji.

A zatem, ile tak naprawdę warta jest jakość obrazu w przeliczeniu na pięć milisekund?

Źródło(a)

NVIDIA (Via YouTube), AMD (Via YouTube), TechSpot, Własne.

Deutsch

Deutsch English

English Español

Español Français

Français Italiano

Italiano Nederlands

Nederlands Polski

Polski Português

Português Русский

Русский Türkçe

Türkçe Svenska

Svenska Chinese

Chinese Magyar

Magyar