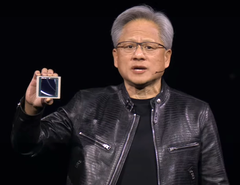

CEO Nvidii, Huang, prezentuje najnowsze produkty AI dla przedsiębiorstw, a także postępy w zakresie autonomicznych pojazdów i robotów humanoidalnych podczas przemówienia na GTC 2024

Dyrektor generalny Nvidia , Jensen Huang ujawnił najnowsze produkty i usługi firmy w zakresie sztucznej inteligencji podczas przemówienia na GTC 2024 18 marca 2024 r. w San Jose w Kalifornii. Nowa oferta Nvidii, skierowana do klientów korporacyjnych, obiecuje znacznie przyspieszyć uczenie się sztucznej inteligencji i jej zastosowanie w wielu dziedzinach, takich jak robotyka, prognozowanie pogody, odkrywanie leków i automatyzacja magazynów. Wśród zaprezentowanych rozwiązań znalazły się GPU Nvidia Blackwell, NIMs, NEMO i AI foundry.

Proces szkolenia AI jest znacznie bardziej intensywny komputerowo niż wykorzystanie modelu AI, ponieważ należy przetworzyć miliony dokumentów wejściowych. Może to zająć tygodnie, a nawet miesiące na najszybszych superkomputerach dostępnych obecnie dla firm takich jak Microsoft. Nvidia wydała wcześniej platformę GPU Hopper w 2022 roku, aby obsłużyć tak duże obciążenia obliczeniowe.

Na GTC 2024 Huang zaprezentował Blackwell jako następcę Hoppera i jest on dostępny na płytce zastępującej obecne instalacje Hopper. Procesor graficzny Blackwell składa się z dwóch matryc GPU o 104 miliardach tranzystorów w procesie TSMC 4NP (prawdopodobnie N4P, literówka w prezentacji) dla 20 petaflopów FP4 z 192 GB pamięci HBM3e zdolnej do przesyłania 8 TB/s. Dla porównania, desktopowy 4090 GPU ma pojedynczy procesor graficzny z 76,3 miliardami tranzystorów, proces technologiczny 5NM, wydajność do 1,32 petaflopsów Tensor FP8 z 24 GB pamięci GDDR6X. Jeśli podwoimy liczbę 4090 FP8, aby dostosować ją do 4-bitów, otrzymamy około 20 petaflopów Blackwell w porównaniu do 3 petaflopów 4090.

Gdy 72 procesory graficzne Blackwell są umieszczone w pojedynczej obudowie DGX GB200 NVL72 w połączeniu z chłodzeniem cieczą, ulepszonymi procesorami NVLinki innymi ulepszeniami połączeń, wydajność w porównaniu do szaf Hopper wzrasta 22-krotnie w przypadku treningu FP8 AI i 45-krotnie w przypadku wnioskowania FP4 AI. Zużycie energii podczas treningu Blackwell AI jest również zmniejszone około 4-krotnie w porównaniu do Hoppera.

Gotowe modele sztucznej inteligencji NIMS

Aby wykorzystać ten skok wydajności, Nvidia wprowadziła wstępnie spakowane modele sztucznej inteligencji o nazwie NIMS (Nvidia Inference Microservice)wykorzystujące Kubernetes do uruchamiania na procesorach graficznych Nvidia CUDA lokalnie lub w chmurze. Dostęp do samodzielnej usługi NIMS odbywa się za pośrednictwem uproszczonego interfejsu API HUMAN. Celem tego jest stworzenie przyszłości, w której usługi sztucznej inteligencji będą tworzone poprzez poproszenie sztucznej inteligencji o stworzenie aplikacji z określonymi funkcjami, a następnie sztuczna inteligencja będzie łączyć i dopasowywać różne NIMS bez konieczności programowania na niskim poziomie. Wreszcie, aby pomóc w szkoleniu NIMS, Nvidia wprowadziła NeMO Microservices aby dostosować, ocenić i zabezpieczyć proces szkolenia w zakresie dokumentów korporacyjnych.

Nvidia BioNeMO i biologiczne NIMS

Huang ogłosił, że Nvidia będzie rozwijać NIMS przeszkolony w zakresie danych biologicznych i medycznych, aby zapewnić naukowcom łatwiejszy dostęp do sztucznej inteligencji, która może poprawić wszystkie aspekty medycyny, takie jak szybsze znajdowanie kandydatów na leki.

Thor ASIL-D i autonomiczne pojazdy elektryczne BYD

Co ważne, Huang stwierdził, że BYD będzie pierwszym producentem samochodów elektrycznych na świecie, który zastosuje swój nowy komputer Thor ASIL-D wykorzystujący SoC AI do przetwarzania danych wizualnych i jazdy w celu zapewnienia wysokiego bezpieczeństwa autonomicznej jazdy. W połączeniu z niedawnym ogłoszeniem SuperDrive by Plussugeruje to, że BYD będzie jedną z pierwszych firm motoryzacyjnych, które wypuszczą na rynek autonomiczny pojazd elektryczny Level 4 autonomicznego pojazdu elektrycznego.

Nvidia Project Groot humanoidalne roboty

Huang zademonstrował swoje postępy w dziedzinie robotyki, prezentując możliwości swoich robotów, które są najpierw szkolone w Omniverse jako cyfrowy bliźniak, a następnie pozwalają im wykonywać zadania w prawdziwych ciałach robotów. Zaprezentowano pieczenie, kręcenie palcami patyczków, sortowanie i składanie produktów oraz omijanie przeszkód. Aby osiągnąć ten poziom robotyki, Nvidia Project Groot AI została stworzona poprzez pierwsze szkolenie na podstawie tekstu, wideo i demonstracji, a następnie dopracowana dzięki rzeczywistym obserwacjom wykonywanych zadań. W połączeniu z tym samym komputerem Thor używanym w pojazdach i modelem językowym Nvidia Tokkio AI modelem językowym, roboty demonstracyjne były w stanie obserwować czynności wykonywane przez ludzi, a następnie replikować je, aby robić drinki, grać na perkusji i odpowiadać na prośby głosowe.

Nvidia Omniverse Cloud dodaje obsługę Apple Vision Pro

Z mniejszych informacji, Huang stwierdził, że Nvidia Omniverse Cloud przesyła teraz strumieniowo do Apple Vision Pro oprócz zestawu słuchawkowego Meta Quest i HTC Vive Prowyraźnie dla deweloperów, którzy wykorzystują procesory graficzne Nvidia w chmurze, ponieważ żaden Macintosh nie ma kompatybilnego procesora graficznego Nvidia.

Czytelnicy, którzy chcą dołączyć do rewolucji AI, będą potrzebować potężnej karty graficznej Nvidia(takiej jak ta w Amazon), aby rozwijać umiejętności i aplikacje AI.

Źródło(a)

NVIDIA wprowadza na rynek superkomputer DGX SuperPOD z procesorami Blackwell do generatywnej sztucznej inteligencji w skali biliona parametrów

Skaluje się do dziesiątek tysięcy superchipów Grace Blackwell przy użyciu najbardziej zaawansowanej sieci NVIDIA, oprogramowania NVIDIA Full-Stack AI i pamięci masowej, oferując do 576 procesorów graficznych Blackwell połączonych jako jeden za pomocą NVIDIA NVLink Eksperci systemowi NVIDIA przyspieszają wdrażanie natychmiastowej infrastruktury AI

18 marca 2024 r

firma GTC-NVIDIA zaprezentowała dziś superkomputer AI nowej generacji - NVIDIA DGX SuperPOD™ napędzany przez układy NVIDIA GB200 Grace Blackwell Superchips - do przetwarzania modeli o trylionach parametrów ze stałym czasem sprawności dla superskalowych generatywnych obciążeń treningowych i wnioskowania AI.

Wyposażony w nową, wysoce wydajną, chłodzoną cieczą architekturę w skali stelaża, nowy DGX SuperPOD jest zbudowany z systemów NVIDIA DGX™ GB200 i zapewnia 11,5 eksaflopsów superkomputerów AI w precyzji FP4 oraz 240 terabajtów szybkiej pamięci - skalując się do większej liczby z dodatkowymi stelażami.

Każdy system DGX GB200 składa się z 36 superukładów NVIDIA GB200 - w tym 36 procesorów CPU NVIDIA Grace i 72 układów GPU NVIDIA Blackwell - połączonych jako jeden superkomputer za pośrednictwem NVIDIA NVLink® piątej generacji. Superukłady GB200 zapewniają nawet 30-krotny wzrost wydajności w porównaniu do procesorów graficznych NVIDIA H100 Tensor Core w przypadku dużych obciążeń związanych z wnioskowaniem na podstawie modeli językowych.

"Superkomputery NVIDIA DGX AI to fabryki rewolucji przemysłowej AI", powiedział Jensen Huang, założyciel i dyrektor generalny firmy NVIDIA. "Nowy DGX SuperPOD łączy w sobie najnowsze osiągnięcia w dziedzinie akceleracji obliczeń, sieci i oprogramowania NVIDIA, aby umożliwić każdej firmie, branży i krajowi udoskonalanie i generowanie własnej sztucznej inteligencji"

Zasilany przez Grace Blackwell DGX SuperPOD składa się z ośmiu lub więcej systemów DGX GB200 i może skalować się do dziesiątek tysięcy Superchipów GB200 połączonych za pośrednictwem NVIDIA Quantum InfiniBand. Aby uzyskać ogromną przestrzeń pamięci współdzielonej do zasilania modeli sztucznej inteligencji nowej generacji, klienci mogą wdrożyć konfigurację, która łączy 576 procesorów graficznych Blackwell w ośmiu systemach DGX GB200 połączonych za pośrednictwem NVLink.

Nowa architektura Rack-Scale DGX SuperPOD dla ery generatywnej sztucznej inteligencji

Nowa architektura DGX SuperPOD z systemami DGX GB200 charakteryzuje się ujednoliconą strukturą obliczeniową. Oprócz NVIDIA NVLink piątej generacji, szkielet ten obejmuje NVIDIA BlueField®-3 DPU i będzie obsługiwał sieć NVIDIA Quantum-X800 InfiniBand, o której poinformowano dziś osobno. Architektura ta zapewnia do 1800 gigabajtów na sekundę przepustowości dla każdego procesora graficznego w platformie.

Dodatkowo, czwarta generacja technologii NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ zapewnia 14,4 teraflopa mocy obliczeniowej w sieci, co stanowi 4-krotny wzrost w architekturze DGX SuperPOD nowej generacji w porównaniu do poprzedniej generacji.

Architektura "pod klucz" w połączeniu z zaawansowanym oprogramowaniem zapewnia niespotykany dotąd czas sprawności

Nowy DGX SuperPOD to kompletny superkomputer AI w skali centrum danych, który integruje się z wysokowydajną pamięcią masową od certyfikowanych partnerów NVIDIA, aby sprostać wymaganiom generatywnych obciążeń AI. Każdy z nich jest zbudowany, okablowany i przetestowany w fabryce, aby znacznie przyspieszyć wdrożenie w centrach danych klientów.

Zasilany przez Grace Blackwell DGX SuperPOD oferuje inteligentne funkcje zarządzania predykcyjnego, które stale monitorują tysiące punktów danych w sprzęcie i oprogramowaniu, aby przewidywać i przechwytywać źródła przestojów i nieefektywności - oszczędzając czas, energię i koszty obliczeń.

Oprogramowanie może identyfikować obszary budzące obawy i planować konserwację, elastycznie dostosowywać zasoby obliczeniowe oraz automatycznie zapisywać i wznawiać zadania, aby zapobiec przestojom, nawet bez obecności administratorów systemu.

Jeśli oprogramowanie wykryje, że konieczna jest wymiana komponentu, klaster aktywuje moc rezerwową, aby zapewnić ukończenie pracy na czas. Wszelkie wymagane wymiany sprzętu można zaplanować, aby uniknąć nieplanowanych przestojów.

Systemy NVIDIA DGX B200 rozwijają superkomputery AI dla przemysłu

NVIDIA zaprezentowała również system NVIDIA DGX B200, ujednoliconą platformę superkomputerową AI do szkolenia, dostrajania i wnioskowania modeli AI.

DGX B200 to szósta generacja chłodzonych powietrzem, tradycyjnych konstrukcji DGX montowanych w stelażach, wykorzystywanych w branżach na całym świecie. Nowy system DGX B200 z architekturą Blackwell zawiera osiem układów GPU NVIDIA Blackwell i dwa procesory Intel® Xeon® 5. generacji. Klienci mogą również budować DGX SuperPOD przy użyciu systemów DGX B200, aby tworzyć centra doskonałości AI, które mogą zasilać pracę dużych zespołów programistów wykonujących wiele różnych zadań.

Systemy DGX B200 zawierają funkcję precyzji FP4 w nowej architekturze Blackwell, zapewniając do 144 petaflopów wydajności AI, ogromne 1,4 TB pamięci GPU i 64 TB/s przepustowości pamięci. Zapewnia to 15-krotnie szybsze wnioskowanie w czasie rzeczywistym dla modeli o trylionach parametrów w porównaniu z poprzednią generacją.

Systemy DGX B200 obejmują zaawansowaną sieć z ośmioma kartami NVIDIA ConnectX™-7 NIC i dwoma jednostkami BlueField-3 DPU. Zapewniają one przepustowość do 400 gigabitów na sekundę na połączenie - zapewniając szybką wydajność sztucznej inteligencji dzięki platformom sieciowym NVIDIA Quantum-2 InfiniBand i NVIDIA Spectrum™-X Ethernet.

Oprogramowanie i wsparcie ekspertów w skalowaniu produkcyjnej sztucznej inteligencji

Wszystkie platformy NVIDIA DGX zawierają oprogramowanie NVIDIA AI Enterprise do opracowywania i wdrażania rozwiązań klasy korporacyjnej. Klienci DGX mogą przyspieszyć swoją pracę dzięki wstępnie wyszkolonym modelom fundamentalnym NVIDIA, frameworkom, zestawom narzędzi i nowym mikrousługom NVIDIA NIM zawartym w platformie oprogramowania.

Eksperci NVIDIADGX i wybrani partnerzy NVIDIA certyfikowani do obsługi platform DG X pomagają klientom na każdym etapie wdrażania, dzięki czemu mogą oni szybko przenieść sztuczną inteligencję do produkcji. Po uruchomieniu systemów eksperci DGX nadal wspierają klientów w optymalizacji ich potoków AI i infrastruktury.

Dostępność

NVIDIA DGX SuperPOD z systemami DGX GB200 i DGX B200 będą dostępne jeszcze w tym roku u globalnych partnerów firmy NVIDIA.

Aby uzyskać więcej informacji, prosimy obejrzeć powtórkę przemówienia na GTC lub odwiedzić stoisko NVIDIA na GTC, które odbędzie się w San Jose Convention Center do 21 marca.

Deutsch

Deutsch English

English Español

Español Français

Français Italiano

Italiano Nederlands

Nederlands Polski

Polski Português

Português Русский

Русский Türkçe

Türkçe Svenska

Svenska Chinese

Chinese Magyar

Magyar